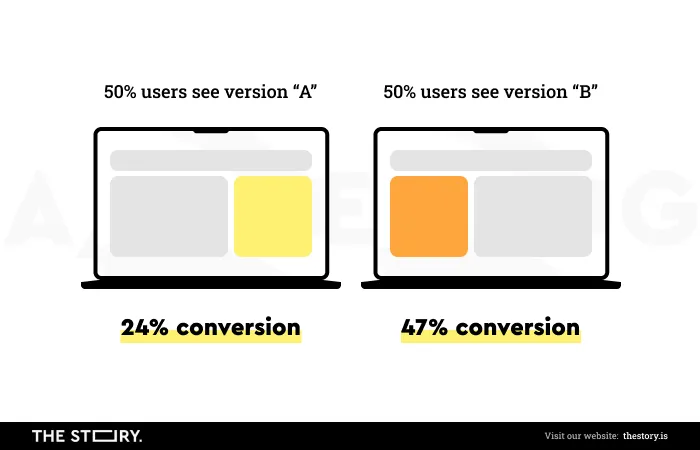

Czym są testy A/B? Zgodnie z popularną definicją, testy A/B są metodą porównania dwóch wariantów projektu (np. formularza kontaktowego) używanych do osiągnięcia tego samego celu.

Celem może być dowolna pożądana - z punktu widzenia właściciela biznesu działającego w internecie - akcja użytkownika strony.

Testy AB to rodzaj eksperymentu, który pozwala sprawdzić, rozstrzygnąć, który wariant jest skuteczniejszy od innych elementów i pozwala osiągać założone cele w sposób bardziej efektywny.

Testy A/B, choć mają bardzo długą tradycję, pełnię swego potencjału i użyteczności nabrały wraz z rozwojem internetu, narzędzi badawczych, dzięki którym ich przeprowadzenie nie stanowi dużego wyzwania organizacyjnego oraz budżetowego.

Właściwie trudno dziś wyobrazić sobie optymalizowanie produktów cyfrowych bez tej metody.

Choć jest ona powszechnie wykorzystywana i na pierwszy rzut oka wydaje się być dostępną nawet dla laików i osób nie posiadających przygotowania i doświadczenia badawczego, to nie można ulec złudzeniu jej łatwości.

Obiegowa opinia głosi, że od braku testów jeszcze gorsze są testy przeprowadzone w sposób nierzetelny, metodologicznie wątpliwy, niezaplanowany.

Warto mieć ją w pamięci decydując się na wykonanie testu A/B.

W jaki sposób należy przeprowadzać testy A/B? Jakie są rodzaje testów A/B? Jakie problemy rodzi ich przeprowadzanie?

Na co należy w szczególności zwracać uwagę w trakcie wykonywania tego rodzaju eksperymentów?

Już za chwilę odpowiemy wyczerpujące na powyższe pytania.

Zapraszamy do lektury!

Jak przeprowadzić test A/B?

Wróćmy jeszcze na chwilę do naszego pytania, co to są testy AB stron internetowych, na czym polegają UX testy AB?

Testy A/B są dziś metodą rozpowszechnioną głównie na gruncie marketingu internetowego, ale nie mniejszą popularnością cieszą się także, gdy chcemy zbadać użyteczność strony internetowej.

Gdy chcemy sprawdzić, który wariant zapewnia użytkownikom lepsze User Experience.

Testy A/B będąc jedną z najbardziej dostępnych metod badawczych powinny stać się stałym narzędziem dla każdej organizacji, która chce skutecznie konkurować, rozwijać się dynamicznie.

Której zależy na oferowaniu użytkownikom, klientom produktów cyfrowych spełniających ich oczekiwania.

Oczekiwania, podobnie jak doświadczenia ewoluują, zmieniają się w czasie.

Stąd też testy A/B powinny być także metodą wykorzystywaną w sposób planowy, regularny, wynikający z przyjętej strategii optymalizacji oraz rozwoju produktu cyfrowego.

Iteracyjne podejście do testów A/B jest dziś uznawane za standardowe.

Testy A/B bardzo często są kojarzone i parowane z innym równie popularnym pojęciem, mianowicie z optymalizacją współczynnika konwersji (CRO - Conversion Rate Optimization).

Konwersja to wszelkie działania użytkownika strony, które są wartościowe z punktu widzenia właściciela biznesu.

Może to być zapis do subskrypcji newslettera, wysłanie zapytania ofertowego, pobranie pliku lub kliknięcie w reklamę.

Testy A/B pozwalają skuteczniej realizować cele biznesowe, mają także pozytywny wpływ na doświadczenia użytkowników.

Co najważniejsze, pozwalają zastąpić przypuszczenia, wyobrażenia, intuicje, przekonania twardymi danymi, które jednoznacznie wskazują, które rozwiązanie działa skuteczniej i przynosi większą korzyść.

Dzięki testom A/B decyzje biznesowe są o wiele bardziej racjonalne. Są oparte na danych, przesłankach mierzalnych, porównywalnych. Optymalizowanie doświadczeń za pomocą testów A/B pozwala także dostrzec skalę różnicy.

Wyniki testów A/B pozwalają udzielać o wiele bardziej trafnych odpowiedzi na kluczowe pytania biznesowe.

Pozwalają uzyskać o wiele lepsze wyniki sprzedażowe, poprawić wyniki współczynnika konwersji, skuteczniej wykorzystywać ruch na stronie.

Na przykład dotyczące kluczowych zmian na stronie głównej, co powinno zwiększyć liczbę konwersji, uniknąć negatywnego wpływu nietrafionych rozwiązań projektowych.

Ponadto, zamiast przysłowiowego “wydaje się nam, że wiemy”, testy A/B pozwalają uzyskać perspektywę “jesteśmy tego prawie pewni i mamy na to dowody”.

Oczywiście, jak to we wszelkich badaniach UX, pewność absolutna jest niemożliwa do osiągnięcia.

Niemniej jednak, testowanie pozwala uzyskać wystarczający poziom pewności do podejmowania korzystnych - z punktu widzenia celów, procesów biznesowych - decyzji.

Jak już wspomnieliśmy, testy A/B wydawać się mogą metodą bardzo prostą i nie wymagającą doświadczenia oraz wiedzy.

To bardzo szkodliwy mit, bowiem od rzetelności, poprawności metodologicznej, sposobu w jaki badanie UX, test użyteczności jest przeprowadzany zależy wartościowość wyników, jakie za jego pomocą zostaną uzyskane.

Od braku badań jeszcze gorsze są źle, niepoprawnie wykonane badania, bowiem wprowadzają one pewność, silne przekonanie o słuszności podjętych decyzji w oparciu o błędne, fałszywe przesłanki.

Jakie są rodzaje testów A/B?

Nim wykonamy właściwe badanie konieczne jest sprawdzenie narzędzia za pomocą którego będziemy testować warianty w obrębie witryny, strony internetowej.

Służą do tego testy A/A, które polegają na porównywaniu dwóch takich samych projektów.

Testy A/A

W efekcie porównania nie powinna pojawić się żadna istotna ze statystycznego punktu widzenia różnica w wynikach.

Testy A/A nie służą do wyłonienia wariantu skuteczniejszego, tylko do zapewnienia maksymalnej wiarygodności uzyskiwanych wyników.

Testy A/A i wyniki uzyskane za ich pomocą pozwalają także uzyskać pewien punkt odniesienia, z którym porównywane będą wyniki właściwych testów.

Zatem, jeśli zależy nam na jakości badania, wiarygodności, jego użyteczności konieczne jest najpierw sprawdzenie samego narzędzia badawczego pod kątem jego dokładności.

Testy A/B/n

Nazwa testy A/B może być trochę myląca. Sugeruje, że porównywać można tylko dwa warianty, co oczywiście nie jest prawdą, bowiem bardzo często wykonuje się testy A/B/n.

Możliwe jest w nich porównywanie dowolnej ilości wariantów.

W testach A/B/n wariant A stanowi wartość kontrolną, a pozostałe warianty są jej odmianami. Zaletą tej metody jest oczywiście wygoda i możliwość dokonania porównania większej ilości projektów.

Ograniczeniem jest czas. Do uzyskania statystycznej istotności wyników zazwyczaj konieczny jest znacznie dłuższy czas.

Testowanie wielowymiarowe (Multivariate Testing - MVT)

Testowanie wielowymiarowe można potraktować jako rozszerzoną wersję testów A/B. O ile w tych ostatnich porównuje się jedną zmienną (np. nagłówek, kolor buttona), o tyle w MVT możliwe jest porównywanie wielu zmiennych jednocześnie.

Dzięki testom wielowymiarowym możliwe jest eksperymentowanie z wieloma kombinacjami (np. interfejsu użytkownika, tekstu).

Pozwala to rozstrzygnąć, która z konfiguracji zmiennych jest najbardziej wydajna, która spotyka się z największym zainteresowaniem użytkowników.

Testowanie wielowymiarowe pozwala sprawdzać na przykład jak dodanie, usunięcie lub edycja wpływa na współczynnik konwersji.

Przy czym trzeba pamiętać, że w testowaniu wielowymiarowym porównujemy, co najmniej dwa elementy, a każdy musi być w dwóch wariantach - stąd też w testach wielowymiarowych testujemy cztery wersje.

Testy wielowymiarowe stanowią także duże wyzwanie organizacyjne. Kolejnym ich ograniczeniem jest brak pewności w kwestii przyczyn popularności danego projektu lub jej braku.

Ciężko jest jednoznacznie i z pełnym przekonaniem stwierdzić, dlaczego dana kombinacja wygrała.

Dlatego też do wyników testów wielowymiarowych należy podchodzić z dużą ostrożnością, co oczywiście nie oznacza, że ich wartość poznawcza jest niska.

Testowanie podzielonego adresu URL (Split URL Testing)

Testowanie podzielonego adresu URL bardzo często jest używane jako synonim testów A/B, ale w rzeczywistości są to dwie różne metody. W testach A/B porównuje się dwa warianty danego elementu strony.

W testach podzielonego adresu URL dokonuje się porównania dwóch różnych wariantów całej strony.

Jest więc to metoda o wiele szersza i pozwalająca porównywać na przykład nowy projekt strony (wersję A) z jego starą wersją (wersję B).

Ograniczeniem testów wielowymiarowych jest konieczność zapewnienia dużego ruchu.

Ponadto, im więcej zmiennych tworzących kombinacje tym więcej wariantów należy poddać testowaniu, co sprawia, że nawet witryny z dużym ruchem mogą mieć problem z uzyskaniem odpowiedniego ruchu na stronie.

Najpopularniejsze elementy testowane za pomocą testów A/B

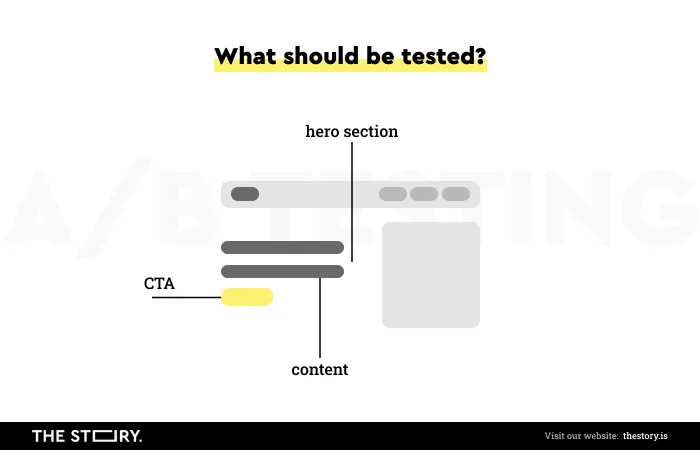

Za pomocą testów A/B najczęściej testowane są:

- nagłówki

- content strony

- layout strony

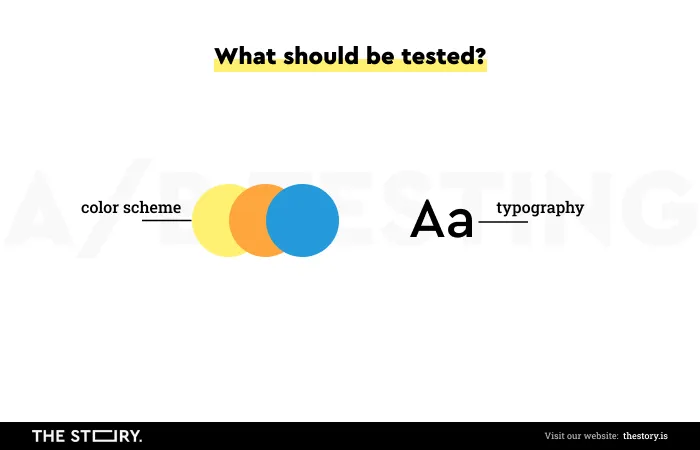

- schematy kolorystyczne strony internetowej

- nawigacja

- formularze

- Call To Action - CTA

- społeczne dowody słuszności (Social Proof)

- systemy ratingowe.

Nagłówki są jednymi z najbardziej dostrzegalnych elementów strony internetowej i pełnią ważną funkcję w strukturze informacji.

Odpowiadają za efekt pierwszego wrażenia, dlatego ich długość, komunikatywność, zrozumiałość, konkretność, jednoznaczność jest kwestią priorytetową.

Nagłówki powinny być ponadto rzeczowe oraz chwytliwe.

Testy A/B pozwalają na wdrożenie zmian, przetestowanie nie tylko wariantów w sensie stylistycznym, językowym, ale także wizualnym (np. poprzez zmianę rozmiaru, rodzaju, koloru, kroju czcionki).

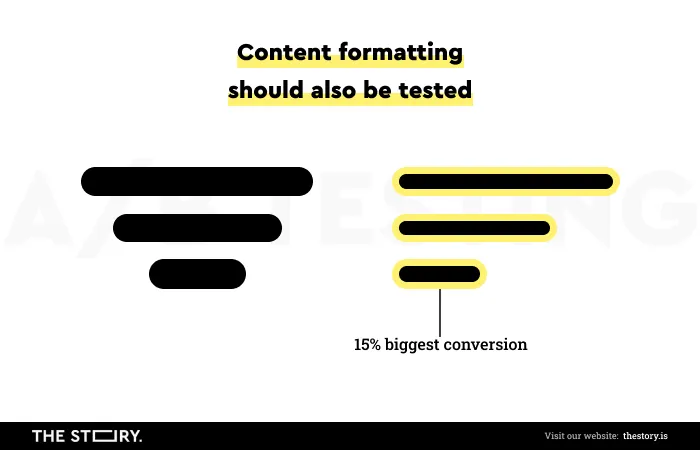

Content strony również można przetestować pod kątem jego czytelności, przyjazności formatowania treści dla użytkownika.

Content strony pełni nie tylko funkcję informacyjną, ale ma także wpływ na konwersję, stąd też odpowiedni styl treści, sposób jej zaprezentowania (układ nagłówków, podtytułów, akapitów, zastosowana typografia, boldowanie, wersaliki) ma ogromne znaczenie.

Przetestowanie wariantów treści pozwala wybrać konfigurację najbardziej korzystną dla użytkowników i właścicieli biznesów.

Layout strony, nawigacja to kolejne bardzo istotne elementy (odpowiedzialne za satysfakcjonujące User Experience), które z pomocą testów A/B mogą być optymalizowane.

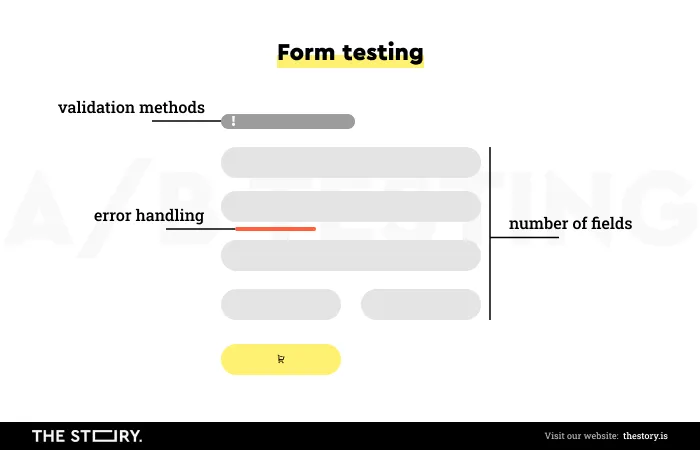

Także tak wymagające i nielubiane elementy stron jak formularze mogą być skutecznie optymalizowane dzięki testom porównawczym.

Ilość pól w formularzu, jego zrozumiałość, sposoby walidowania, obsługa błędów i wiele innych problemów, jakie wiążą się z projektowaniem formularzy może być sprawdzona pod kątem ich atrakcyjności i wydajności właśnie dzięki testom A/B.

Statystyka i prawidłowości testowania A/B

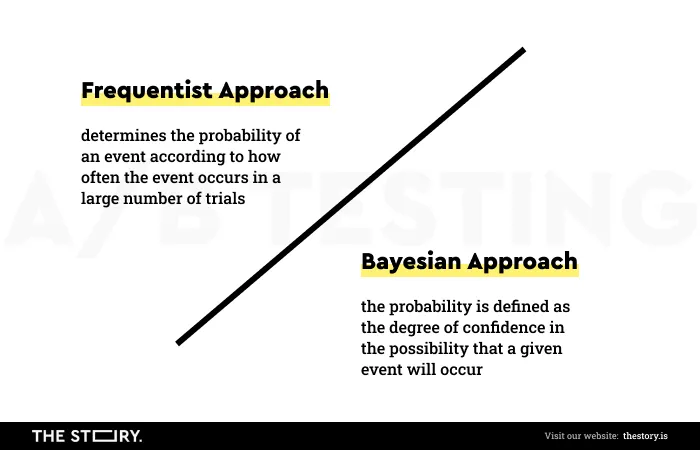

Wykonując testy A/B wykorzystuje się dwa podejścia statystyczne:

- Frequentist Approach

- Bayesian Approach.

Frequentist Approach określa prawdopodobieństwo zdarzenia w zależności od tego, jak często dane zdarzenie występuje w dużej liczbie prób.

Innymi słowy, by wyciągać wiążące, trafne wnioski na podstawie wyników konieczne jest wykonanie testów przez dłuższy czas i na większej ilości użytkowników używających danych wariantów.

W tym podejściu wykorzystywane są tylko dane z bieżącego eksperymentu.

W Bayesian Approach prawdopodobieństwo definiowane jest jako stopień wiary w możliwość wystąpienia danego zdarzenia (np. skorzystania z formularza kontaktowego).

Proces przewidywania jest uwarunkowany zakresem, głębokością oraz zróżnicowaniem informacji oraz uformowanej na nich wiedzy.

Mówiąc bardziej jasnym językiem, im więcej wiemy o danym zdarzeniu, tym trafniej i szybciej możemy przewidzieć wynik.

Prawdopodobieństwo w tym podejściu nie jest wartością stałą, ale zmienną, którą kształtuje przyrost informacji oraz wiedzy.

Bayesian Approach pozwala ponadto:

- wykorzystywać dane historyczne (np. uzyskane wyniki we wcześniejszych testach)

- uzyskiwać wyniki szybciej bez ryzyka ich nierzetelności, nietrafności

- przeprowadzać badania w bardziej czasowo elastyczny sposób.

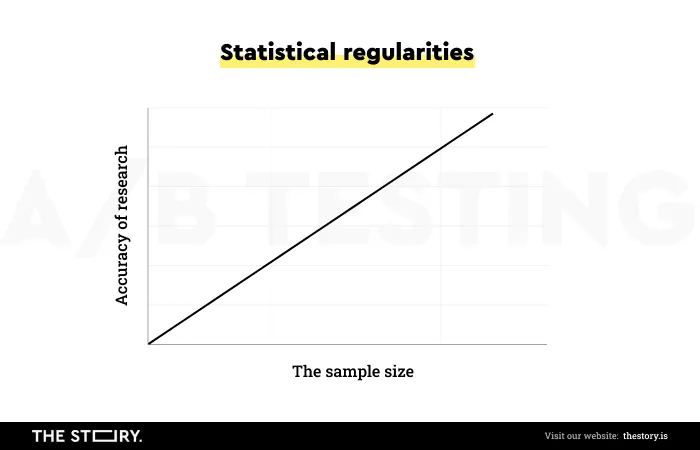

Analizując wyniki testów A/B warto mieć także świadomość kilku statystycznych prawidłowości, zasad oraz zależności.

Przykładowo:

- im większa wielkość próby, tym średnia jest bardziej dokładna

- im wyższa zmienność, tym mniej dokładna będzie średnia w przewidywaniu pojedynczego punktu danych

- im niższy poziom istotności statystycznej, tym większe prawdopodobieństwo, że wariant zwycięski faktycznie nim może nie być

- im bardziej ekstremalne wyniki w pierwszym pomiarze, tym większe prawdopodobieństwo, że wyniki będą bliższe średniej w drugim pomiarze.

Metodologia przeprowadzania testu AB

Skrupulatne przestrzeganie procedur zalecanych przy wykonywaniu testów A/B jest nie tyle rekomendowane, co po prostu konieczne, by uzyskać wyniki wiarygodne i użyteczne pod względem projektowym i biznesowym.

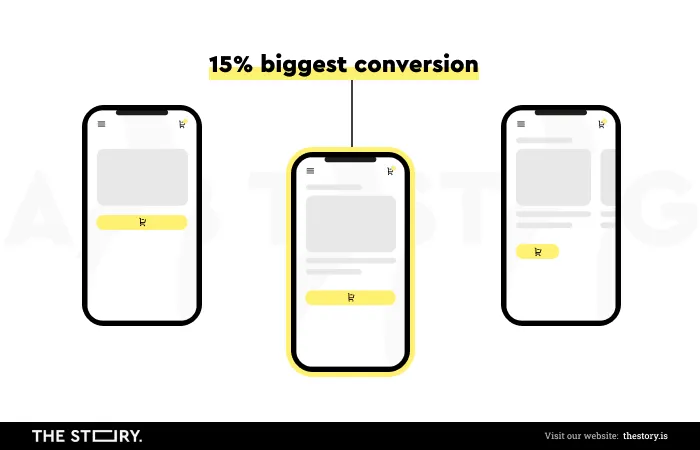

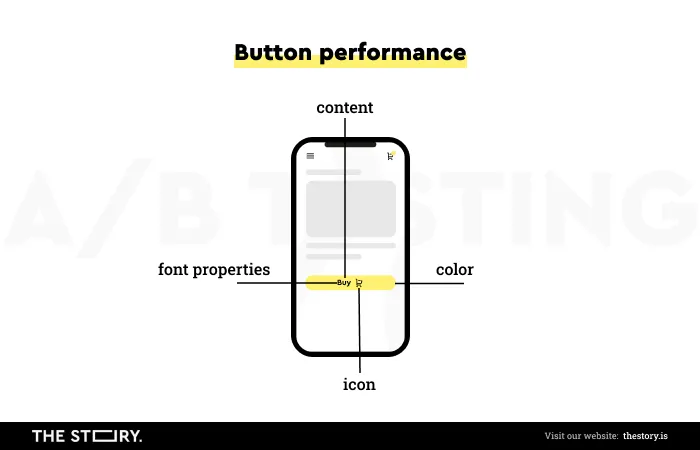

Odwołajmy się do przykładu. Załóżmy, że chcemy zbadać skuteczność przycisku, na przykład przycisku “Dodaj do koszyka”, którego bieżące wyniki są niezadowalające.

Precyzyjne określenie problemu badawczego, zdefiniowanie, co chcemy badać, za pomocą jakich metryk jest kluczowe.

W tym konkretnym przypadku będziemy mierzyć wydajność przycisku manipulując tylko jedną zmienną. Na przykład kolorystyką, wielkością fontu lub treścią wezwania do działania.

Przy czym nie chodzi o generowanie pomysłów na badanie, ale o postawienie konkretnej hipotezy, którą da się sfalsyfikować lub potwierdzić.

Na przykład: zmiana koloru z czerwonego na żółty powoduje zwiększenie współczynnika konwersji.

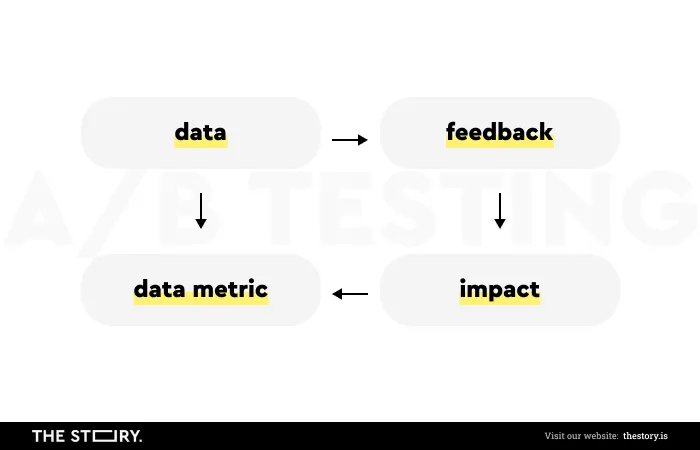

W formułowaniu hipotez bardzo pomocne jest wzorzec zaproponowany przez Craiga Sullivana w artykule pt. Hypothesis Kit 3.

Ma on następującą formę:

- Ponieważ obserwujemy dane (Data) / mamy informacje zwrotne (Feedback)

- Możemy oczekiwać, że zmiana (Change) spowoduje wpływ (Impact)

- Który możemy zmierzyć za pomocą metryk (Data Metric).

Ilość kliknięć w przycisk w danym wariancie będzie stanowić wskaźnik wydajności, będzie naszą metryką.

Im więcej osób kliknie w przycisk w danym przedziale czasowym, tym wydajność przycisku będzie większa w porównaniu do pozostałych wariantów.

W następnym kroku należy określić czas, ile ma trwać test. Jego długość powinna być ustalana na podstawie historycznych wyników na stronie i spodziewanego ruchu.

Warto pamiętać, że ruch będzie podzielony na dwa warianty, zatem należy to uwzględnić w przyjętych założeniach.

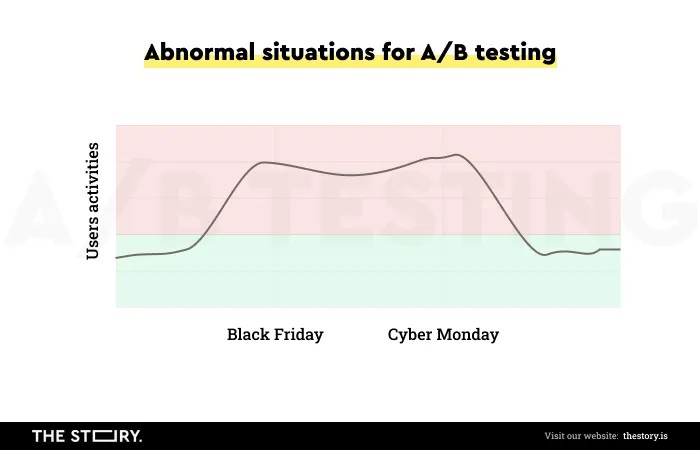

Kwestią, której nie można pominąć jest problem czynników zewnętrznych, sytuacji nietypowych lub odbiegających od powszechnej normy, które mogą wpływać na wyniki.

Chodzi głównie o moment, w którym ruch jest zwiększony względem średniej, na przykład w:

- okresie promocji (np. Black Friday, Cyber Monday)

- prowadzonych działań reklamowych

- pór roku - w szczególności ma to znaczenie w branżach, w których sezonowość jest istotną zmienną.

Sytuacje powyższe w sensie statystycznym stanowią anomalię i mogą powodować błędne wyniki. Wariant skuteczniejszy w okresach wyjątkowych w pozostałym czasie może być mniej skuteczny.

Istotne jest także uwzględnienie źródła ruchu (Mobile vs Desktop), bowiem kanał w jakim następuje interakcja jest zmienną warunkującą wyniki.

By były one wiarygodne i możliwe do porównania, testy muszą być wykonane w identycznych uwarunkowaniach i kontekstach.

Na gruncie statystycznej teorii projektowania eksperymentów taką praktykę nazywa się blokowaniem (Blocking).

Blokowanie redukuje niewyjaśnioną zmienność oraz pozwala uzyskać większą precyzyjność wyników.

W zależności od potrzeb, celów badawczych, przyjętych hipotez możliwe jest bardziej szczegółowe segmentowanie użytkowników, także pod kątem innych zmiennych (np. lokalizacji).

Mając przygotowane badanie oraz warianty, stworzone na podstawie przyjętej hipotezy lub hipotez, które będą porównywane z wersją kontrolną, możemy uruchomić test na jednym z licznych narzędzi dostępnych do przeprowadzania testów A/B.

Bodaj jednym z najbardziej popularnych narzędzi jest Google Optimize. Google Optimize pozwala w podstawowej wersji bezkosztowo przeprowadzić testy.

Popularne błędy popełniane w czasie testów A/B

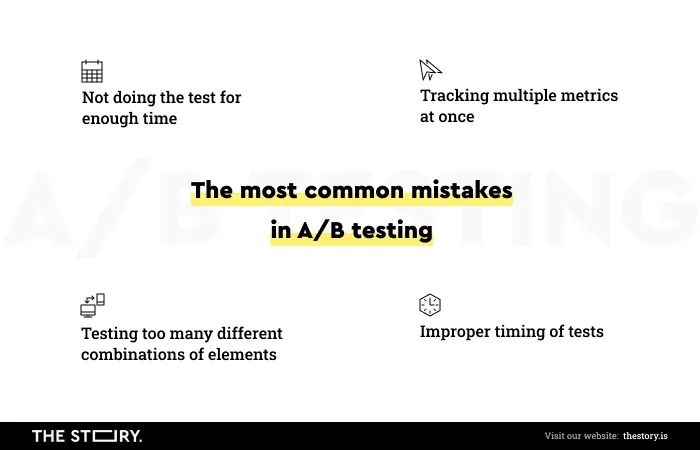

Jednym z najczęściej popełnianych błędów podczas wykonywania testów A/B (np. w czasie testowanie landing page) jest ich przedwczesne zakończenie.

Pokusą do takich działań są wyniki, które potwierdzają hipotezę badawczą. Wydaje się, że jest ona słuszna, a dalsze testowanie jest co najmniej stratą cennego czasu.

W literaturze przedmiotowej tego rodzaju błąd nazywa się P-hackingiem lub wątpliwymi praktykami badawczymi (Questionable Research Practices - QRP).

Popełniane są przez badaczy, którzy chcąc potwierdzić swoje hipotezy badawcze łamią założenia wnioskowania statystycznego.

Równie częstym błędem jest niepodejmowanie ponownych badań. Ryzyka wystąpienia fałszywego wyniku nigdy nie można lekceważyć, stąd też ponawianie badań jest po prostu konieczne i bardzo pożądane.

Trzeba także pamiętać, że same preferencje użytkowników podlegają ewolucji, zmieniają się w czasie, dlatego ich diagnozowanie jest bezwzględnie rekomendowane.

Długość testów oraz wielkość próby powinna być każdorazowo dostosowywana do problemu badawczego, hipotezy, wielkości ruchu oraz okresu, w jakim badanie ma być przeprowadzone.

Ilość wariantów, hipotez ogólnych oraz szczegółowych także przekłada się na czas badania oraz wielkość próby, która pozwala uzyskać statystyczną istotność.

Jakość samego ruchu, jego zrównoważenie ma ogromny wpływ na jakość wyników testów.

Jak prawidłowo przeprowadzić testy A/B. Podsumowanie

- Co to są testy A/B? Test A B jest metodą dwóch wariantów projektu, używanych do osiągnięcia tego samego celu.

- Za pomocą testu AB rozstrzygniemy, który wariant jest skuteczniejszy i pozwala osiągać założone cele w sposób bardziej efektywny.

- Testy A/B UX są metodą stosowaną do badania użyteczności strony internetowej.

- Rekomendowane jest korzystanie z testów A/B w sposób regularny, powtarzalny.

- Są metodą badawczą zwiększającą efektywność, atrakcyjność, przyjazność, użyteczność, jaką cechuje się strona internetowa jako taka oraz poszczególne elementy w witrynie, reklamy.

- Testy AB UX pozwala poprawić współczynnik konwersji (CRO - Conversion Rate Optimization).

- Gdy optymalizujemy witrynę pozwalają zastąpić przypuszczenia, wyobrażenia, intuicje, przekonania twardymi danymi, pozwalają udzielać o wiele bardziej trafnych odpowiedzi na kluczowe pytania biznesowe (np. jak zwiększyć współczynnik konwersji, jak uzyskać wyższy CTR?

- Pozwalają także osiągać o wiele lepsze wyniki sprzedażowe, skuteczniej wykorzystywać ruch na stronie.

- Od rzetelności, poprawności metodologicznej testu, testowania, sposobu, w jaki cały proces jest przeprowadzany zależy wartościowość wyników, jakie za jego pomocą zostaną uzyskane.

- Testy A/A służą do zapewnienia maksymalnej wiarygodności uzyskiwanych wyników.

- Testy A/B/n umożliwiają porównywanie dowolnej ilości wariantów.

- Test wielowymiarowy, testy wielowymiarowe pozwalają porównywać elementy strony, różne wersje jednocześnie, możliwe kombinacje (np. pozwalają porównywać warianty karty produktów, co jest szczególnie istotne, gdy prowadzisz sklep internetowy).

- W testach podzielonego adresu URL dokonuje się porównania dwóch różnych wariantów całej strony.

- Za pomocą testów A/B najczęściej testowane są nagłówki, content, layout strony, schematy kolorystyczne, nawigacja. Służą bardzo często do optymalizacji konwersji, strony docelowej, implementacji skuteczniejszych funkcjonalności na stronę internetową.

- W momencie przeprowadzania testu A/B wykorzystuje się dwa podejścia statystyczne Frequentist Approach, Bayesian Approach.

- By uzyskać wyniki wiarygodne i użyteczne pod względem projektowym i biznesowym, wepierające strony docelowe, ich rozwój, należy przestrzegać wytycznych metodologicznych.

- Długość testów oraz wielkość próby powinna być każdorazowo dostosowywana do problemu badawczego, hipotezy, wielkości ruchu, okresu (nie należy ich wykonywać w okresie dużej anomalii).